Izvorna verzija od ova priča pojavio se u Magazin Quanta.

Veliki jezični modeli djeluju dobro jer su tako veliki. Najnoviji modeli iz OpenAi, Meta i DeepSeek koriste stotine milijardi „parametara“ – podesivih gumba koje određuju veze među podacima i postaju podešeni tijekom postupka treninga. S više parametara, modeli su bolje prepoznati uzorke i veze, što ih zauzvrat čini snažnijim i točnijim.

Ali ta snaga dolazi po cijenu. Obuka modela sa stotinama milijardi parametara uzima ogromne računalne resurse. Na primjer, kako bi trenirao svoj Blizanci 1.0 Ultra model, Google je navodno potrošio 191 milijuna dolara. Veliki jezični modeli (LLMS) također zahtijevaju značajnu računalnu snagu svaki put kada odgovore na zahtjev, što ih čini notornim energetskim svinjama. Jedan upit za chatgpt konzumira oko 10 puta onoliko energije kao i pojedinačna Google pretraga, prema Institutu za istraživanje električne energije.

Kao odgovor, neki istraživači sada razmišljaju o malom. IBM, Google, Microsoft i Openai nedavno su objavili modele malih jezika (SLMS) koji koriste nekoliko milijardi parametara – dio svojih LLM kolega.

Mali se modeli ne koriste kao alati opće namjene poput njihovih većih rođaka. Ali oni se mogu istaknuti na određenim, usko definiranim zadacima, poput sažetka razgovora, odgovaranje na pitanja pacijenata kao chatbot u zdravstvu i prikupljanje podataka u pametnim uređajima. “Za puno zadataka, model od 8 milijardi parametara zapravo je prilično dobar”, rekao je Zico Kolterračunalni znanstvenik na Sveučilištu Carnegie Mellon. Oni se također mogu pokrenuti na prijenosnom računalu ili mobitelu, umjesto u ogromnom podatkovnom centru. (Ne postoji konsenzus o točnoj definiciji “malih”, ali novi modeli maksimalno izlaze oko 10 milijardi parametara.)

Kako bi optimizirali postupak obuke za ove male modele, istraživači koriste nekoliko trikova. Veliki modeli često istječu podatke o sirovom treningu s interneta, a ti podaci mogu biti neorganizirani, neuredni i teško ih je obraditi. Ali ovi veliki modeli tada mogu generirati visokokvalitetni skup podataka koji se može koristiti za obuku malog modela. Pristup, nazvan destilacija znanja, dobiva veći model da učinkovito pređe na svoju obuku, poput učitelja koji predaje učenicima. “Razlog [SLMs] Budite toliko dobri s tako malim modelima i tako mali podaci su da koriste visokokvalitetne podatke umjesto neurednih stvari “, rekao je Kolter.

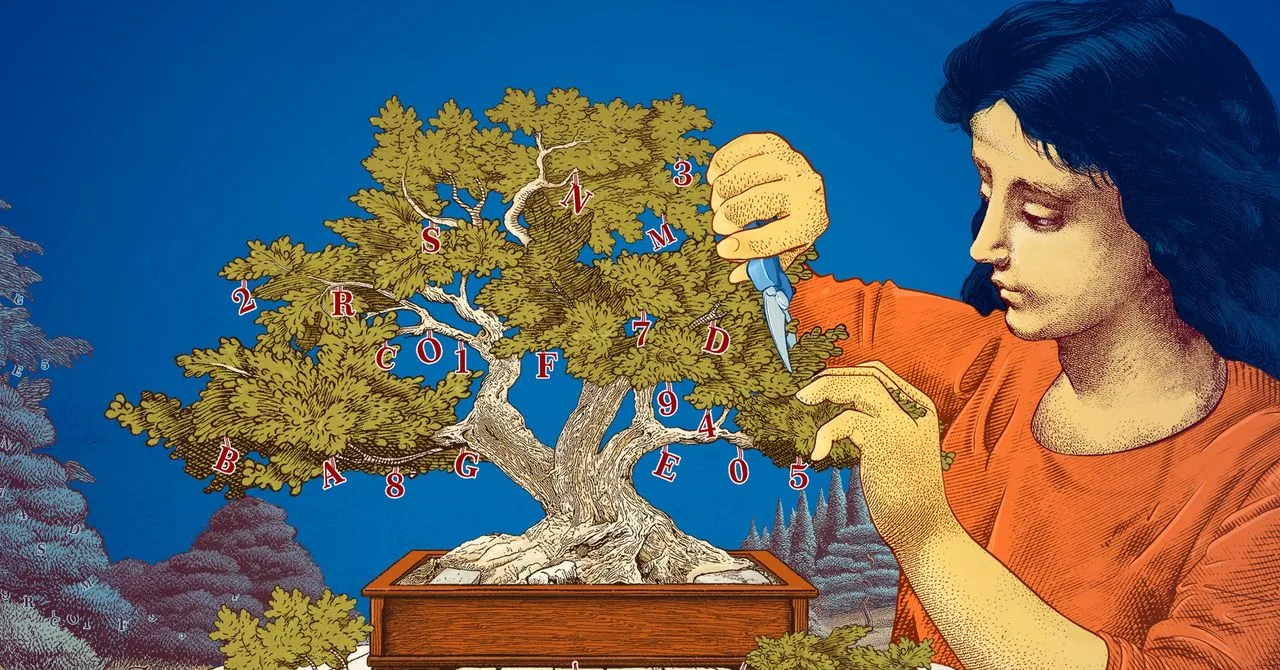

Istraživači su također istraživali načine stvaranja malih modela počevši s velikim i obrezuju ih. Jedna metoda, poznata kao obrezivanje, podrazumijeva uklanjanje nepotrebnih ili neučinkovitih dijelova a neuronska mreža– Rasprostranjena mreža spojenih podatkovnih točaka koje su u osnovi velikog modela.

Obrezivanje je inspirirano neuronskom mrežom u stvarnom životu, ljudskim mozgom, koji postiže učinkovitost šmrkanjem veza između sinapsi kao osobe dobi. Današnje obrezivanje približava se tragu do rad iz 1989. godine U kojem je računalni znanstvenik Yann Lecun, koji je sada na Meta, tvrdio da se do 90 posto parametara u obučenoj neuronskoj mreži može ukloniti bez žrtvovanja učinkovitosti. Metodu je nazvao “optimalnim oštećenjem mozga.” Obrezivanje može pomoći istraživačima da preciziraju mali jezični model za određeni zadatak ili okruženje.

Za istraživače koji su zainteresirani za to kako jezični modeli rade ono što rade, manji modeli nude jeftin način testiranja novih ideja. A budući da imaju manje parametara od velikih modela, njihovo obrazloženje moglo bi biti transparentnije. “Ako želite napraviti novi model, trebate isprobati stvari”, rekao je Leshem choshenistraživački znanstvenik u laboratoriju MIT-IBM Watson AI. “Mali modeli omogućuju istraživačima eksperimentiranje s nižim ulozima.”

Veliki, skupi modeli, sa svojim sve većim parametrima, ostat će korisni za aplikacije poput generaliziranih chatbota, generatora slika i Otkrivanje droge. No, za mnoge korisnike, mali, ciljani model će raditi jednako dobro, a istraživačima će biti lakše trenirati i graditi. “Ovi učinkoviti modeli mogu uštedjeti novac, vrijeme i izračunati”, rekao je Choshen.

Originalna priča ponovljena s dopuštenjem iz Magazin Quanta,, urednička neovisna publikacija Fondacija Simons Čija je misija poboljšati javno razumijevanje znanosti pokrivanjem razvoja istraživanja i trendova iz matematike i fizičkih i životnih znanosti.